Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

Tags

- Deep Learning

- 딥러닝

- 2022

- 논문 리뷰

- GAN

- Neural Radiance Field

- Vae

- IROS

- ICCV 2021

- CVPR2023

- linux

- 리눅스

- 파이토치

- ICCV

- panoptic segmentation

- pytorch

- Computer Vision

- paper review

- 논문리뷰

- 논문

- Paper

- 융합연구

- panoptic nerf

- NeRF paper

- NERF

- docker

- Python

- 경희대

- CVPR

- Semantic Segmentation

Archives

- Today

- Total

윤제로의 제로베이스

Learning Object-Compositional Neural Radiance Field for Editable Scene Rendering(ICCV 2021) 본문

Self Paper-Seminar/NeRF

Learning Object-Compositional Neural Radiance Field for Editable Scene Rendering(ICCV 2021)

윤_제로 2023. 4. 2. 23:54Learning Object-Compositional Neural Radiance Field for Editable Scene Rendering(ICCV 2021)

https://zju3dv.github.io/object_nerf/

Introduction

이 논문에서 추구하는 contribution은 다음과 같다.

- the first editable neural scene rendering system given a collection of posed images and 2D instance masks

- design a novel two-pathway architecture to learn object compositional neural radiance field

- the experiment and extensive ablation study demonstrate the effectiveness of our system and the design of each component

Method

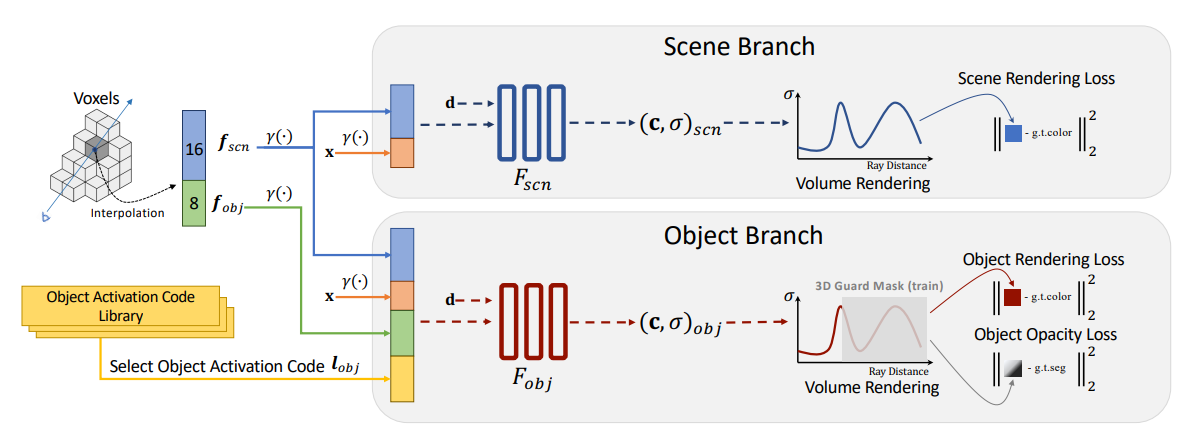

Framework of Object-Compositional NeRF

Scene Branch: 전체적인 scene의 geometry와 appearance를 encode

Object Branch: Learnable Object Activation Code와 standalone object를 encode

Object-Compositional Learning: Object supervision

일단 K개의 annotated object의 learnable object code library를 사용한다.

Loss 수식에서 첫 줄은 Rendered object color와 Real color를 mask를 한 상태로 MSE를 진행하는 것을 보여주고, 바로 밑에는 Rendered object opacity와 ground truth instance mask의 MSE를 계산하는 것이다.

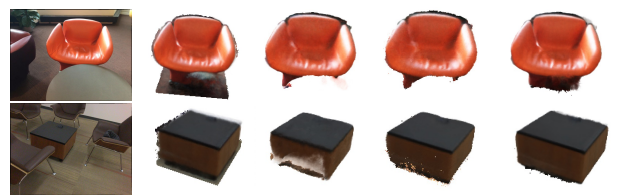

Object-Compositional Learning: Occlusion issue

여기서 말하는 Occlusion issue라 함은 아래의 그림처럼 object가 다른 object에 가려져 rendering을 할 때 제대로 되지 않는 issue를 말한다.

Object-Compositional Learning: Scene-guided occlusion identification

위와 같은 occlusion을 방지하기 위해서 scene branch로부터 얻은 geometric cue를 사용한다.

scene guidance가 occluded region에 대해서 point sampling하지 않도록 하면서 erroneous도 완화한다.

Object-Compositional Learning: 3D guard mask

Editable Scene Rendering

참조

- Yang, Bangbang, et al. "Learning object-compositional neural radiance field for editable scene rendering." Proceedings of the IEEE/CVF International Conference on Computer Vision. 2021.

- https://zju3dv.github.io/object_nerf/

'Self Paper-Seminar > NeRF' 카테고리의 다른 글

| Panoptic NeRF: 3D-to-2D Label Transfer for Panoptic Urban Scene Segmentation (0) | 2023.05.01 |

|---|---|

| Panoptic NeRF (0) | 2023.04.26 |

| GNeRF: GAN-based Neural Radiance Field without Posed Camera(ICCV 2021) (0) | 2023.04.02 |

| Point-NeRF: Point-based Neural(CVPR2022) (0) | 2023.01.12 |

| Light Field Networks: Neural Scene Representations with Single-Evaluation Rendering (0) | 2022.11.23 |